Im Wettbewerb um Technologien und Zukunftsmärkte spielen Normen und Standards eine entscheidende Rolle. Das Positionspapier »Wer sie gestaltet, beherrscht den Markt: Normen und Standards« der Fraunhofer-Gesellschaft weist darauf hin, wie wichtig die Gestaltung von Normung und Standardisierung ist und formuliert entsprechende Handlungsempfehlungen. Ein besonders wichtiges Handlungsfeld in der Normung und Standardisierung betrifft den Bereich Künstliche Intelligenz und Autonome Systeme. Das Fraunhofer IESE gestaltet diesen Bereich maßgeblich mit und setzt Qualitätsstandards im Hinblick auf Verlässlichkeit und insbesondere Safety.

Anwendungsbereichsübergreifende Aktivitäten bezüglich Safety von KI-basierten autonomen Systemen

Die Normierung von KI und autonomen Systemen ist essenziell, um Sicherheit und Zuverlässigkeit zu gewährleisten. Standards schaffen Transparenz, fördern Interoperabilität und ermöglichen Vertrauen. Sie stellen sicher, dass KI-Systeme auch in kritischen Bereichen sicher und effektiv arbeiten. Deswegen engagiert sich das Fraunhofer IESE in zahlreichen nationalen und internationalen Normierungsgremien.

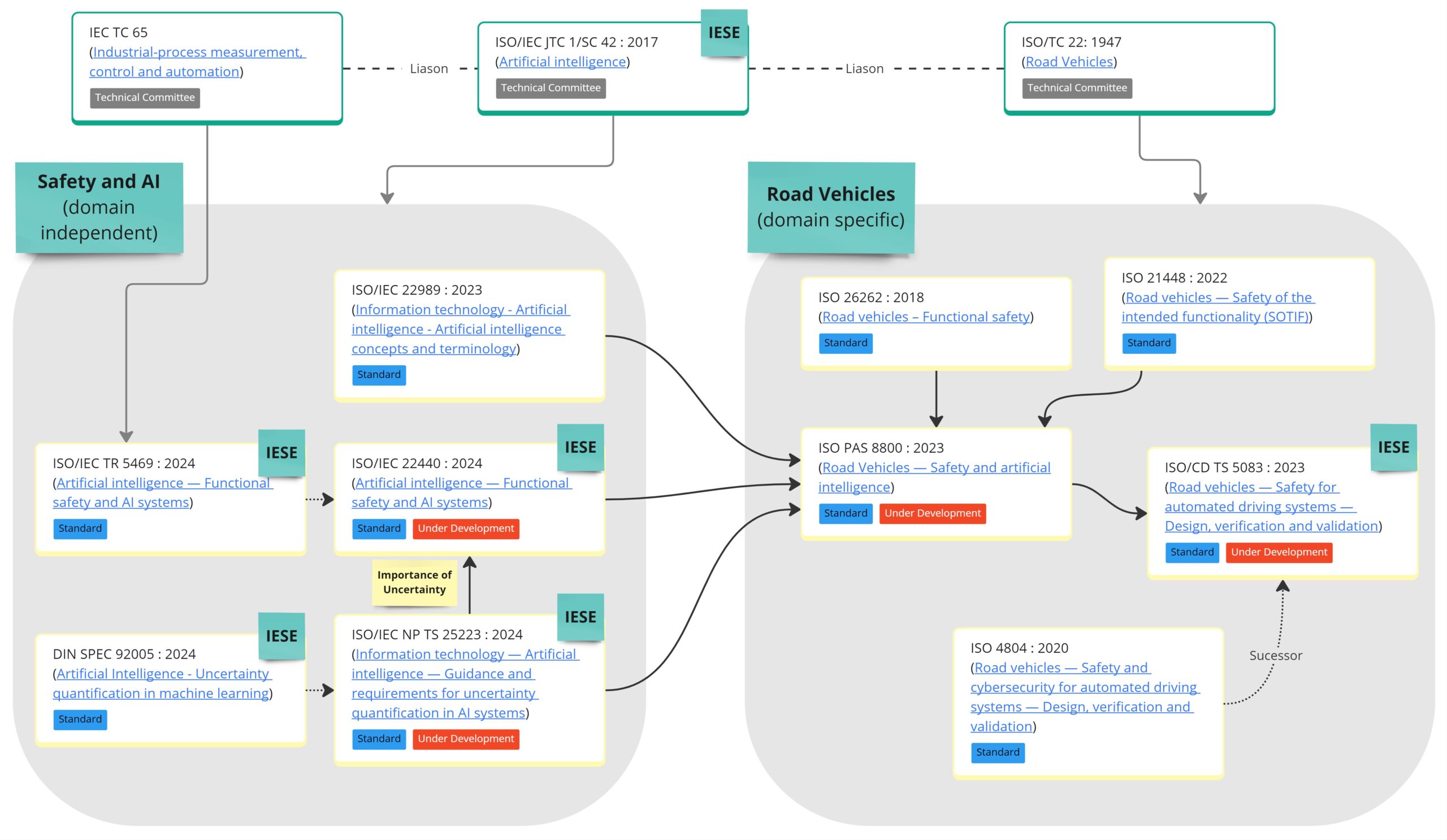

Auf internationaler Ebene arbeiten die beiden großen Normungsorganisationen IEC und ISO zusammen, um die Normierung und Standardisierung bezüglich Autonomer Systeme und Künstlicher Intelligenz voranzubringen, und zwar im Komitee ISO/IEC JTC 1/SC 42 »Künstliche Intelligenz«. Hier wird beispielsweise auch die internationale Definition der Begriffe »Künstliche Intelligenz« und »Autonomie« erarbeitet. Im Hinblick auf funktionale Sicherheit arbeitet das Komitee ISO/IEC JTC 1/SC 42 mit der Normungsgruppe zusammen, die das Thema »Funktionale Sicherheit« behandelt und die anwendungsübergreifende Sicherheitsgrundnorm IEC 61508 auf dem neuesten Stand hält. Ein Ergebnis dieser Zusammenarbeit wird beispielsweise der technische Report ISO/IEC AWI TR 5469 Artificial intelligence — Functional safety and AI systems sein. Der zugehörige deutsche Arbeitskreis ist der AK 914.0.11 Funktionale Sicherheit und künstliche Intelligenz. Das Fraunhofer IESE beteiligt sich aktiv sowohl im AK 914.0.11 als auch in der internationalen Liaison.

Verlässlichkeit ist mehr als funktionale Sicherheit

Um die Verlässlichkeit autonomer Systeme zu gewährleisten, muss allerdings mehr berücksichtigt werden als nur die funktionale Sicherheit. Dazu zählen beispielsweise die dynamische Vernetzung zwischen Systemen und der komplexe Anwendungskontext vieler autonomer Systeme. In der Arbeitsgruppe DKE/AK 801.0.8 »Spezifikation und Entwurf autonomer / kognitiver Systeme« bringt das Institut seine Lösungen und seine System-Safety-Expertise in die Anwendungsregel VDE-AR-E 2842-61 Development and trustworthiness of autonomous/cognitive systems ein (siehe hier für weiterführende Informationen).

Durch Synergien zur konsistenten Sicherheitsnormierung

Bei der Vielzahl an Handlungsfeldern und Aktivitäten ist es wichtig, die Übersicht zu behalten. An dieser Stelle kommt dem Normenausschuss NA 043-01-42 GA »Künstliche Intelligenz« eine besondere Bedeutung zu. Die großen deutschen Normungsorganisationen DIN und DKE arbeiten hier zusammen, um nationale Aktivitäten zu koordinieren und Verbindungen zu europäischen sowie internationalen Aktivitäten herzustellen. Letzteres beinhaltet insbesondere die Spiegelung der europäischen Aktivitäten im CEN-CENELEC JTC 21 »Artificial Intelligence« und die internationalen Aktivitäten im bereits erwähnten ISO/IEC JTC 1/SC 42. Das Fraunhofer IESE unterstützt den NA 043-01-42 GA dabei, Lücken in der Normierung und Standardisierung zu erkennen, Synergien zwischen aktuellen Aktivitäten zu schaffen und Konsistenz der Ergebnisse zu garantieren.

Anwendungsbereichsspezifische Aktivitäten bezüglich Safety von KI-basierten autonomen Systemen

Die Sicherheitsgrundnorm IEC 61508 adressiert keinen bestimmten Anwendungsbereich wie Avionics oder Automotive. Um den Unterschieden in den verschiedenen Anwendungsbereichen gerecht zu werden, gibt es Normen, die von der IEC 61508 abgeleitet sind, aber auf Besonderheiten des Anwendungsbereichs eingehen. Für den Bereich Automotive ist dies beispielsweise die ISO 26262. Das Konzept der abgeleiteten Normen ist auch für die notwendigen Anpassungen bezüglich KI-basierten autonomen Systemen sinnvoll. Eine Ableitung setzt allerdings voraus, dass es bereits etwas gibt, von dem abgeleitet werden kann. Dies ist momentan noch nicht der Fall, da anwendungsübergreifende Aktivitäten noch nicht abgeschlossen sind und die Ergebnisse noch keine Norm sind, sondern weniger verbindliche Dokumente wie technische Reports oder Anwendungsregeln. Um keine Zeit zu verlieren, gibt es allerdings trotzdem eine Reihe von anwendungsbereichsspezifischen Aktivitäten.

Aktivitäten im Anwendungsbereich »Industrielle Anwendungen«

Der Expertenrat für Künstliche Intelligenz in industriellen Anwendungen (DKE/AK STD 1941.0.8 SCI 4.0) hat beispielsweise die Normierung rund um das Thema Safety koordiniert. Dies spiegelt sich auch in seinem Beitrag zur ersten KI-Normungsroadmap wider. Das Fraunhofer IESE wirkte hier insbesondere beim Thema »Sichere, verlässliche Systeme« mit.

Bei der zweiten deutschen Normungsroadmap wurde das Thema Safety unter Leitung des IESE anwendungsübergreifend adressiert, da sehr viele Aspekte in allen Anwendungsbereichen eine Rolle spielen. Dazu gehört der Umgang mit der Unsicherheit beim Maschinellen Lernen. Die nationale DIN SPEC 92500 definiert den Begriff Unsicherheit und wird als Ausgangsbasis für den internationalen Standard ISO/IEC NP TS 25223 verwendet. Technische Regelwerke, welche die Sicherheit von KI-Systemen adressieren, können dann alle auf die gleiche Definition von Unsicherheit verweisen, und Inkonsistenzen zwischen Anwendungsbereichen können vermieden werden. Der technische Report ISO TR 5469, der sich mit der »Funktionalen Sicherheit von KI-Systemen« befasst, adressiert bereits den Umgang mit KI-Unsicherheiten. In der darauf aufbauenden technischen Spezifikation ISO/IEC WD TS 22440 werden voraussichtlich konkretere Anforderungen zum Umgang mit Unsicherheit formuliert. Die deutsche Anwendungsregel für Vertrauenswürdigkeit von autonomen/kognitiven Systemen VDE-AR-E 2842-61 führt dazu, unsicherheitsbezogene Fehler als eine neue Fehlerklasse einzustufen (neben systematischen und zufälligen Fehlern).

Im Kontext des Komitees IEC/TC 44/WG 14 »Safety of Machinery—Electrosensitive protective equipment—Safety-related sensors used for protection of person« bringt das Institut seine Expertise zur Umsetzung innovativer intelligenter Schutzfunktionen ein.

Aktivitäten im Anwendungsbereich »Automotive«

Im Bereich Automotive nutzt das Fraunhofer IESE die Kollaborationsplattform »The Autonomous«, um Innovationsthemen wie dynamisches Risikomanagement zu behandeln. Ein weiterer thematischer Schwerpunkt betrifft die Erstellung eines strukturierten Sicherheitsnachweises (Assurance Case). Insbesondere im Bereich Automotive gewinnt die Erstellung eines solchen Nachweises an Bedeutung, wie man an der UL 4600 oder geplanten Aktivitäten im Kontext des ISO/NP PAS 8800 Road Vehicles — Safety and Artificial Intelligence erkennt.

Was bedeuten diese Aktivitäten für mein Unternehmen?

In erster Linie sind die genannten Aktivitäten relevant für Zulieferer, Integratoren und Hersteller von sicherheitskritischen Produkten. Allerdings richten sie sich auch verstärkt an Betreiber, da es bei KI-basierten autonomen Systemen neue Fragestellungen bezüglich der Rolle des Betreibers gibt. Zu dem traditionellen Fokus auf Safety zum Zeitpunkt zur Markteinführung kommt verstärkt die Aufrechterhaltung der Safety nach der Markteinführung.

Wenn Sie Fragen zum »Normendschungel« haben und wissen wollen, ob er eher eine Chance oder ein Risiko für Ihr Unternehmen darstellt, dann können Sie uns gerne kontaktieren.